Regresión lineal: Interpretación de Coeficientes

En esta entrada se recoge una explicación simple para facilitar la interpretación de modelos de regresión lineal simple y múltiple cuando todas las variables independientes son cuantitativas continuas, sin entrar en detalle de supuestos matemáticos subyacentes a dichos análisis.

Los análisis de regresión lineal son de los más utilizados en nuestro campo y se encuentran dentro del modelo lineal general. Este tipo de análisis ofrecen una gran versatilidad para el estudio de múltiples hipótesis de investigación, pudiendo aportar información muy útil. En esta entrada nos centraremos en al interpretación de la regresión lineal cuando todas las variables del modelo son cuantitativas continuas. Vamos a distinguir tres formas de regresión lineal:

- Regresión lineal simple.

- Regresión lineal múltiple sin interacción.

- Regresión lineal múltiple con interacción.

Notación matemática

Este sería el modelo más sencillo de regresión lineal, donde se dispone de una variable dependiente (y) y una sola variable independiente (x), que quedaría definido matemáticamente como:

$$y_i = c + b_1x_i + \epsilon_i$$

Por otro lado, visualmente un modelo de regresión lineal quedaría definido en un gráfico de dispersión como:

Para poder comprender los modelos de regresión lineal múltiples más avanzados, es necesario empezar a entender la notación matemática utilizada en la regresión lineal. A continuación se muestra a que hace referencia cada letra de la anterior fórmula:

- yi = Esta es la variable dependiente, la que se intenta «predecir» en función de los valores de las variables independientes. El subíndice i hace referencia al sujeto i del que se está intentando predecir el valor de y.

- c = Esta es la constante del modelo, el valor en el que la recta de regresión corta el eje de las ordenadas, es decir, el valor de y cuando x = 0.

- xi = Esta es la variable independiente, la que se utiliza para «predecir» los valores de y. Puede haber más de una, que pueden nombrarse con cualquier otra letra, aunque es habitual usar posteriormente w y z. Estas serán las letras a utilizar en los ejemplos de esta entrada.

- b1 = Este es el coeficiente de regresión sin estandarizar, estos coeficientes se calculan siguiendo el método de los mínimos cuadrados ordinarios. Hay un coeficiente de regresión sin estandarizar por cada variable independiente incluida en el modelo.

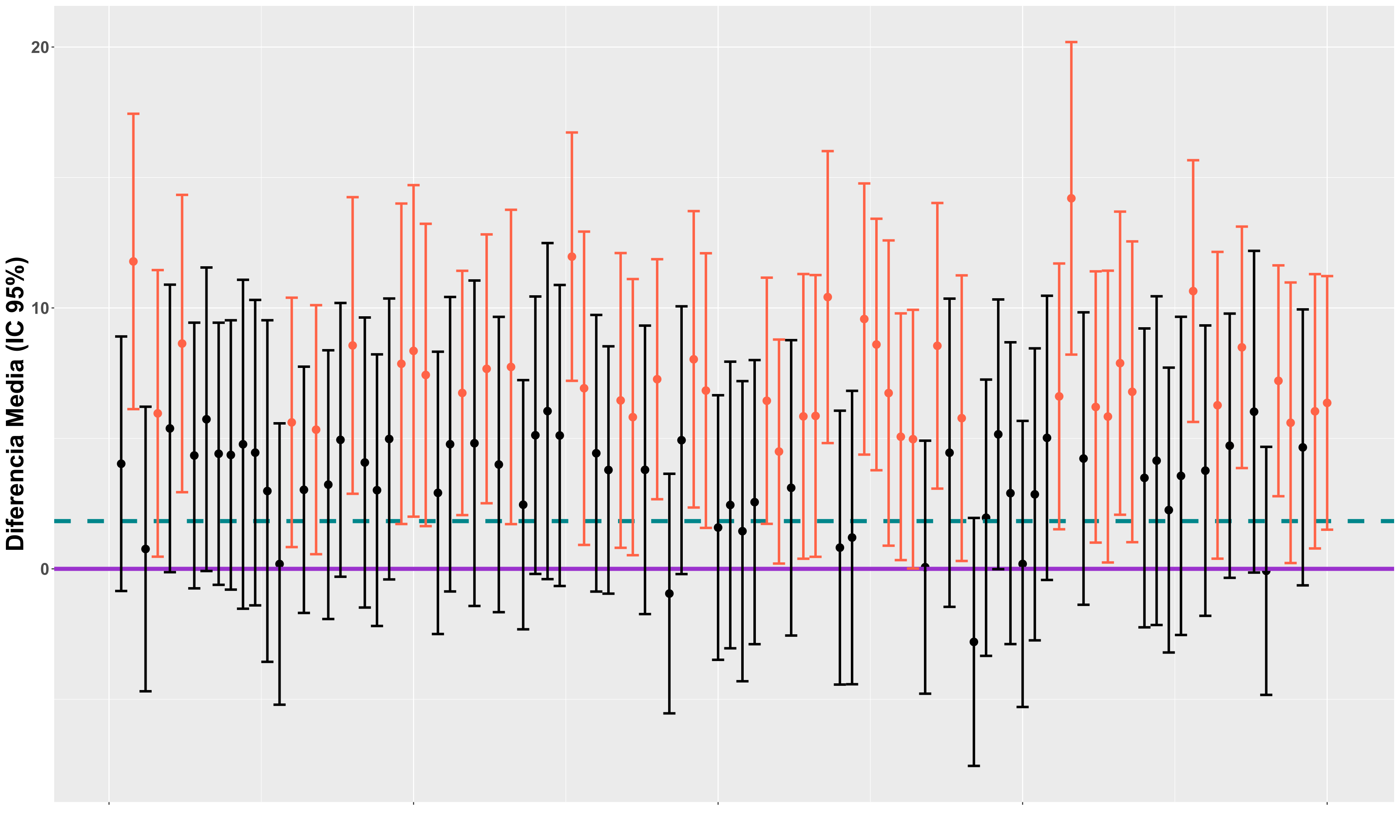

- ϵi = Este es el error asociado al sujeto i. Normalmente, este término no se incluye en la notación de la fórmula del modelo de regresión lineal, aunque se tiene en cuenta para los análisis estadísticos. En la gráfica se refleja el error asociado a cada sujeto con una línea vertical anaranjada, que es la distancia del valor observado en el sujeto hasta la recta de regresión, que es el valor que predecimos en función de nuestra variable/s independiente/s.

Una vez conocidos los términos, podemos pasar a comprender como interpretar un análisis de regresión lineal simple y posteriormente múltiple.

Regresión lineal simple

En la fórmula mostrada anteriormente, yi hacía referencia al valor observado para el sujeto i en la variable dependiente, dado que se incluyó el término del error (ϵi) en la fórmula. Cuando dejamos fuera este término, yi hace referencia al valor predicho de la variable dependiente y para el sujeto i (el valor de la recta de regresión). De ahora en adelante, hablaremos siempre del valor predicho, que es lo que realmente se estima con los modelos de regresión lineal. Pero… ¿Qué es el valor predicho?

A lo largo de toda la página web me veréis insistir mucho en entender conceptos básicos como diferenciar estimadores muestrales de estimadores individuales, así como la importancia de comprender adecuadamente el concepto de tendencia central y más en concreto, el de la media. El valor predicho con un modelo de regresión lineal es una media. Si partimos de un valor cualquiera de la variable independiente (x), por ejemplo x = 68kg, el valor predicho de la variable dependiente (y = Fuerza) sería la fuerza media estimada de todos los sujetos que presentan un peso de 68kg. *Nota: Debemos tener en cuenta que puede haber muchas mal-especificaciones en el modelo de regresión, por ejemplo porque no haya una relación lineal y sea de otro tipo, que no hayamos tenido en cuenta todas las variables posibles a incluir en el modelo o que nuestra muestra no sirva para generalizar el modelo a otras (ej. sujetos jóvenes sin generalizar a la tercera edad), pero no entraremos en detalle en estos puntos en esta entrada.

Se ha comentado que b1 es el coeficiente de regresión sin estandarizar. Se le denomina sin estandarizar porque no se han manipulado las unidades de medida a la hora de su cálculo, presenta las mismas unidades que la variable dependiente, en el caso de una regresión lineal simple el coeficiente de regresión estandarizado sería igual al coeficiente de correlación de Pearson. Este coeficiente es el que nos indica la posible presencia o no de una relación lineal entre la variable independiente y la dependiente, su interpretación sería la siguiente:

- b1 < 0. Relación negativa entre las dos variables.

- b1 = 0. Ausencia de relación entre las dos variables.

- b1 > 0. Relación positiva entre las dos variables.

La ausencia de estandarización conlleva un problema, no podemos saber como de grande es o no es la relación lineal con respecto a otros coeficientes de otros modelos de regresión lineal (a diferencia de con el coeficiente de correlación de Pearson, que si podemos), debido a que su valor depende de las unidades de medida de x e y. Es decir, imaginemos que queremos predecir la fuerza isométrica máxima de rotación externa de hombro en función del índice de masa corporal y por otro lado, en función de la estatura, quedando dos modelos de regresión lineal simple como los siguientes:

$$Fuerza_i = 32.54 + 5.10*IMC_i$$

$$Fuerza_i = -65.93 + 1.27*Estatura_i$$

Como puede apreciarse, en ambos casos existe una relación positiva, ya que el coeficiente de regresión sin estandarizar es mayor que cero (5.10 para la fuerza y 1.27 para la estatura). Sin embargo, aunque el valor del coeficiente de la estatura sea menor que el del IMC, ambas variables presentan la misma relación con la fuerza, un coeficiente de correlación de Pearson de 0.50 en ambos casos. La discrepancia observada en los coeficientes sin estandarizar es debida a que las unidades de medida del IMC y la estatura difieren, siento en este caso simulado:

$$IMC = \{\bar x = 23kg/m^2, \sigma = 3kg/m^2\}$$

$$Estatura = \{\bar x = 170cm, \sigma = 12cm\}$$

Esto mismo sucedería si cambiásemos de variable dependiente, ya que sus unidades también influyen en el valor del coeficiente de regresión sin estandarizar. De aquí en adelante, nos olvidaremos de medir lo «grande» o «pequeña» que es la relación lineal y nos centraremos simplemente en interpretar los modelos de regresión lineal con coeficientes sin estandarizar.

En una regresión lineal simple, el coeficiente b1 hace referencia al cambio estimado en unidades de y que se deriva de incrementar una unidad en x. Por ejemplo, en el caso anterior de la estatura, por cada incremento en 1cm de estatura se estima un incremento de 1.27N de fuerza de rotación externa. Retomando la representación gráfica de la regresión lineal simple, el coeficiente b1 haría referencia a la pendiente de la recta de regresión.

Regresión lineal múltiple sin interacción

Ya sabemos a que hace referencia el coeficiente b1 cuando solo hay una variable independiente en el modelo, pero ¿Qué interpretación tienen estos coeficientes cuando tenemos más de una variable independiente? Establezcamos un nuevo modelo, donde se pretenda predecir la fuerza en rotación externa incluyendo la estatura y el peso como variables independientes:

$$y_i = c + b_1 x_i + b_2 w_i$$

$$Fuerza_i = c + b_1*Peso_i + b_2*Estatura_i$$

$$Fuerza_i = -251.14 + 3.98*Peso_i + 0.96*Estatura_i$$

Cuando en un modelo de regresión lineal se incluyen dos o más variables dependientes por separado, estamos forzando al modelo a un supuesto, que no existe interacción entre el peso y la estatura a la hora de predecir la fuerza, es decir, que la relación estimada del peso con la fuerza es independiente de la estatura y la relación estimada de la estatura con la fuerza es independiente del peso. La definición por tanto de los coeficientes sin estandarizar sería:

- b1 = Cambio estimado en unidades de y que se deriva de incrementar 1kg el peso, manteniendo la estatura constante.

- b2 = Cambio estimado en unidades de y que se deriva de incrementar 1cm la estatura, manteniendo la peso constante.

Es decir, si tenemos dos personas con la misma estatura, por ejemplo 170cm, una que pesa 68kg y otra que pesa 69kg, la diferencia de fuerza que estimamos entre ellas es de 3.98N (b1). Esto se cumpliría para cualquier valor de estatura, siempre que ambos sujetos tengan la misma. Del mismo modo, si tenemos dos personas que pesan lo mismo, una que mide 170cm y otra que mide 171cm, la diferencia de fuerza que estimamos entre ellas es de 0.96N (b2), a expensas del peso que presenten, siempre que sea el mismo.

Expresado desde un punto de vista gráfico (por ejemplo para el peso), la pendiente (b1) de la recta de regresión obtenida de predecir la fuerza en función del peso no varía en función de la estatura:

En esta imagen se reflejan las recta de regresión entre el peso y la fuerza, para cinco valores de estatura (de 162cm a 178cm), calculadas a partir de las fórmulas mostradas anteriormente. Como puede apreciarse, la pendiente de las rectas es idéntica, son rectas paralelas donde lo único que cambia es la constante, ejemplificando visualmente la definición aportada anteriormente.

Hay dos conceptos que suelen nombrarse mucho en relación a los análisis de regresión lineal múltiple, el de factor de confusión y/o covariable. Hay situaciones en las que queremos estimar la relación que tiene una variable con otra, «controlando» para otros posibles factores de confusión, denominados covariables del modelo. Por ejemplo, podríamos querer estimar la relación lineal que hay entre la intensidad del dolor de hombro y la fuerza isométrica en rotación externa, controlando para las covariables edad, estatura y peso.

Regresión lineal múltiple con interacción

Como se ha comentado anteriormente, al incluir solo por separado las dos variables independientes, se fuerza el modelo a asumir que la relación estimada por ejemplo del peso con la fuerza, es independiente del valor de estatura de los sujetos y viceversa, que esto se traducía en que el valor del coeficiente de regresión del peso (b1) no varía en función de la estatura, que la pendiente de dicha recta de regresión es la misma, como se podía apreciar en la última figura. Antes de pasar a explicar que es la interacción, creo que es mejor observar una representación gráfica de la misma con el mismo modelo anterior:

Como se puede apreciar, en este caso, la pendiente de la recta de regresión para el peso si varia en función de la estatura de los sujetos, es decir, el coeficiente de regresión del peso (b1) varía en función de la estatura. Para entender esto, primero debemos conocer como se expresa un modelo de regresión lineal múltiple con interacción y a que hace referencia dicha interacción:

$$y_i = c + b_1 x_i + b_2 w_i + b_3 z_i$$

$$Fuerza_i = c + b_1*Peso_i + b_2*Estatura_i + b_3*Interaccion$$

$$Fuerza_i = c + b_1*Peso_i + b_2*Estatura_i + b_3*Peso_i*Estatura_i$$

Tal y como se refleja en estas fórmulas, un modelo de regresión lineal con interacción es aquel en el que se incluye un tercer término en el modelo (la interacción), con su respectivo coeficiente de regresión (b3). Ese tercer término no es más que una variable que se crea multiplicando los valores de las otras dos incluidas en el modelo, es decir, si un sujeto tiene una estatura de 170cm y un peso de 72kg, su valor en la variable interacción sería de 12240. ¿A qué hace referencia aquí entonces el coeficiente de regresión de la interacción (b3)?

Podemos definir b3 como el cambio estimado del coeficiente de regresión del peso (b1) que se deriva del incremento de una unidad en la estatura (+ 1cm), o viceversa, el cambio estimado del coeficiente de regresión de la estatura (b2) que se deriva del incremento de una unidad en el peso (+ 1kg). Voy a centrarme en el coeficiente de regresión del peso para explicar mejor esta definición, reestructurando un poco la fórmula mostrada anteriormente. Imaginemos que es viable tener una estatura de 0cm e incrementamos en una unidad la estatura, teniendo por tanto un valor de estatura para un sujeto dado de 1cm, entonces sustituyendo en la anterior fórmula tendríamos que:

$$Fuerza_i = c + b_1*Peso_i + b_2*Estatura_i + b_3*Peso_i*Estatura_i$$

$$Fuerza_i = c + b_1*Peso_i + b_2*1 + b_3*Peso_i*1$$

$$Fuerza_i = (c + b_2) + Peso_i*(b_1 + b_3)$$

He puesto dentro de un mismo paréntesis la constante y el coeficiente b2 puesto que al multiplicarlo por 1 quedaría un valor numérico, que se sumaría a la constante. Por otro lado, al adjudicar el valor 1 a la estatura en el término de la interacción, lo que queda es un coeficiente de regresión multiplicado solo por la variable peso, de modo que se puede unificar dicho coeficiente (b3) con el coeficiente b1 en un mismo paréntesis, quedando ambos multiplicados por el peso. Es aquí donde queda ejemplificada la definición mostrada anteriormente, de que el coeficiente de regresión del peso ha incrementado b3 unidades debido al incremento de una unidad en la estatura, ya que si la estatura tuviera un valor hipotético de cero, entones:

$$Fuerza_i = c + b_1*Peso_i + b_2*Estatura_i + b_3*Peso_i*Estatura_i$$

$$Fuerza_i = c + b_1*Peso_i + b_2*0 + b_3*Peso_i*0$$

$$Fuerza_i = c + Peso_i*b_1$$

Quedando ejemplificado que el incremento de una unidad de la estatura es lo comentado anteriormente. En términos de visualización gráfica, la pendiente de la recta de regresión entre el peso y la fuerza se incrementaría b3 unidades con el incremento de una unidad en la estatura.

De esta última fórmula se extrae además otra definición nueva. Mientras que en la regresión lineal múltiple sin interacción el coeficiente de regresión del peso (b1) hacia referencia a la relación entre el peso y la fuerza, independiente de la estatura (manteniendo la estatura constante), ahora el coeficiente de regresión del peso (b1) refleja la relación entre el peso y la fuerza cuando la estatura es igual a cero, sucediendo lo mismo pero a la inversa para el coeficiente de la estatura. Es decir, la inclusión del término de interacción cambia el significado de los coeficientes de regresión del peso (b1) y la estatura (b2), esto es importante ya que, si no se conoce este hecho, se pueden malinterpretar gravemente dichos coeficientes al leer un artículo de investigación. Normalmente, cuando se incluye un término de interacción, lo que interesa es el coeficiente de regresión de la interacción, que es lo que se suele estar testando, no esos otros coeficientes.

Puede que te hayas dado cuenta ya de un factor importante sobre la interpretación de dichos coeficientes de regresión al incluir la interacción, ¿Cómo que b1 es la relación entre el peso y la fuerza cuando la estatura es igual a cero? ¿Quién puede medir cero centímetros? No tiene sentido. Es por ello que para mejorar la interpretación de dichos coeficientes, suele realizarse un procedimiento que se denomina «centrar en la media». *Nota: Aunque no es el objetivo de esta entrada y no profundizaré en ello, si quería remarcar que el objetivo de centrar en la media es puramente para hacer que esos coeficientes tengan un sentido de interpretación, nada que ver la «eliminación» de la colinealidad entre variables independientes con el objetivo de mejorar el modelo de regresión, ya que no sirve para tal propósito.

Este procedimiento consiste en restar a cada valor el de la media de la muestra para dicha variable, es decir, si un sujeto tiene un peso de 55kg pero la media muestral es de 60kg, entonces su valor quedaría como -5. Esta actuación no alterará el coeficiente de regresión de la interacción ni la significación estadística del mismo, solo alterará los otros dos coeficientes de las variables implicadas en la interacción, en nuestro caso b1 y b2. En este caso, por ejemplo para el peso, b1 ya no sería la relación entre el peso y la fuerza cuando la estatura es igual a cero, sería la relación entre el peso y la fuerza cuando la estatura es igual a la media de la muestra, y lo mismo sucedería con b2. Por tanto, ahora si tienen un sentido interpretable ambos coeficientes.

En esta entrada no profundizaré más en la interpretación de una interacción, ni en que pasos habría que seguir después de haber evaluado si hay o no una interacción estadísticamente significativa. No obstante, pondré un ejemplo más con 3 variables independientes. Imaginemos ahora el siguiente modelo de regresión lineal múltiple con interacción:

$$Fuerza_i = c + b_1*Peso_i + b_2*Estatura_i + b_3*Edad_i + b_4*Peso_i*Estatura_i$$

En este caso tenemos 3 variables independientes incluidas en el modelo, así como un término de interacción, la interacción entre la estatura y el peso. Por ejemplo para el peso, su coeficiente de regresión (asumiendo que hemos centrado en la media), sería la relación entre el peso y la fuerza cuando la estatura tiene el valor de la media de la muestra y se mantiene la edad constante, es decir, si la estatura media de la muestra fuese de 170cm, b1 sería la diferencia de fuerza estimada entre dos sujetos que miden 170cm y tienen la misma edad, se cual sea esta, pero que presentan una diferencia entre ellos de 1kg de peso. Por otro lado, el coeficiente de regresión de la edad (b3) sería la relación entre la edad y la fuerza, manteniendo constantes la estatura y el peso, es decir, la diferencia de fuerza estimada entre dos sujetos que tienen la misma estatura y peso, sean cuales sean estos, pero que difieren en 1 año de edad. En otras palabras, la inclusión de una interacción solo cambia la interpretación de los coeficientes de regresión de las variables involucradas en la misma, no las del resto de variables incluidas en el modelo. Este principio de razonamiento de interpretación se aplicaría en modelos más complejos, con varias interacciones y más variables independientes incluidas. Pondré un último ejemplo:

$$Fuerza_i = c + b_1*Peso_i + b_2*Estatura_i + b_3*Edad_i + b_4*Peso_i*Estatura_i*Edad_i*$$

En este caso se ha incluido una interacción entre las 3 variables (edad, estatura y peso), de forma que el coeficiente de regresión de la edad (b3) pasaría a ser, asumiendo que hemos centrado en la media, la relación entre la edad y la fuerza cuando la estatura y el peso tienen los valores de la media de la muestra.

Según se van incluyendo más variables e interacciones en el modelo, su interpretación puede volverse algo más tediosa y es por eso que no profundizaré en modelos más avanzados en esta entrada, pues pienso requerirían de demasiado tiempo y una base previa profunda de conocimiento de estadística para no errar en la interpretación de los mismos.

Conclusiones

A pesar de ser métodos de análisis ampliamente extendidos dentro del campo de la Fisioterapia, mi sensación subjetiva es que existe mucho desconocimiento sobre como interpretar los mismos. En esta entrada he querido profundizar solo en la parte de interpretación del sentido de los coeficientes de regresión, algo que a priori podría parecer complejo pero en verdad no lo es tanto. Finalmente, quiero remarcar que la interpretación crítica adecuada de un modelo de regresión lineal múltiple, requiere de tener en cuenta más aspectos que los mencionados en esta entrada, la cual constituye simplemente una base para comenzar a comprender mejor este tipo de análisis estadísticos.

Cambio Intra- & Entre-Grupos en Ensayos Aleatorizados

Ensayos aleatorizados: Cambio intra- & entre-grupos En esta entrada se recoge una breve explicación de los cambios intra-grupos y entre-grupos dentro del …

Tamaño Muestral: Potencia Observada En esta entrada se recoge una breve explicación del concepto de potencia observada y los motivos por los …

Tamaño Muestral ANOVA mixto GPower

Tamaño muestral: NOTA SOBRE TAMAÑOS DEL EFECTO EN ANOVAS DE MEDIDAS REPETIDAS con G*Power En esta entrada se recoge una breve explicación …

repositorio: tamaño muestral modelos predictivos Minimum sample size for developing a multivariable prediction model: Part I – Continuous outcomes | Stat Med …